Tolong, Berhenti Pakai AI Browser (Bagian II dari II)

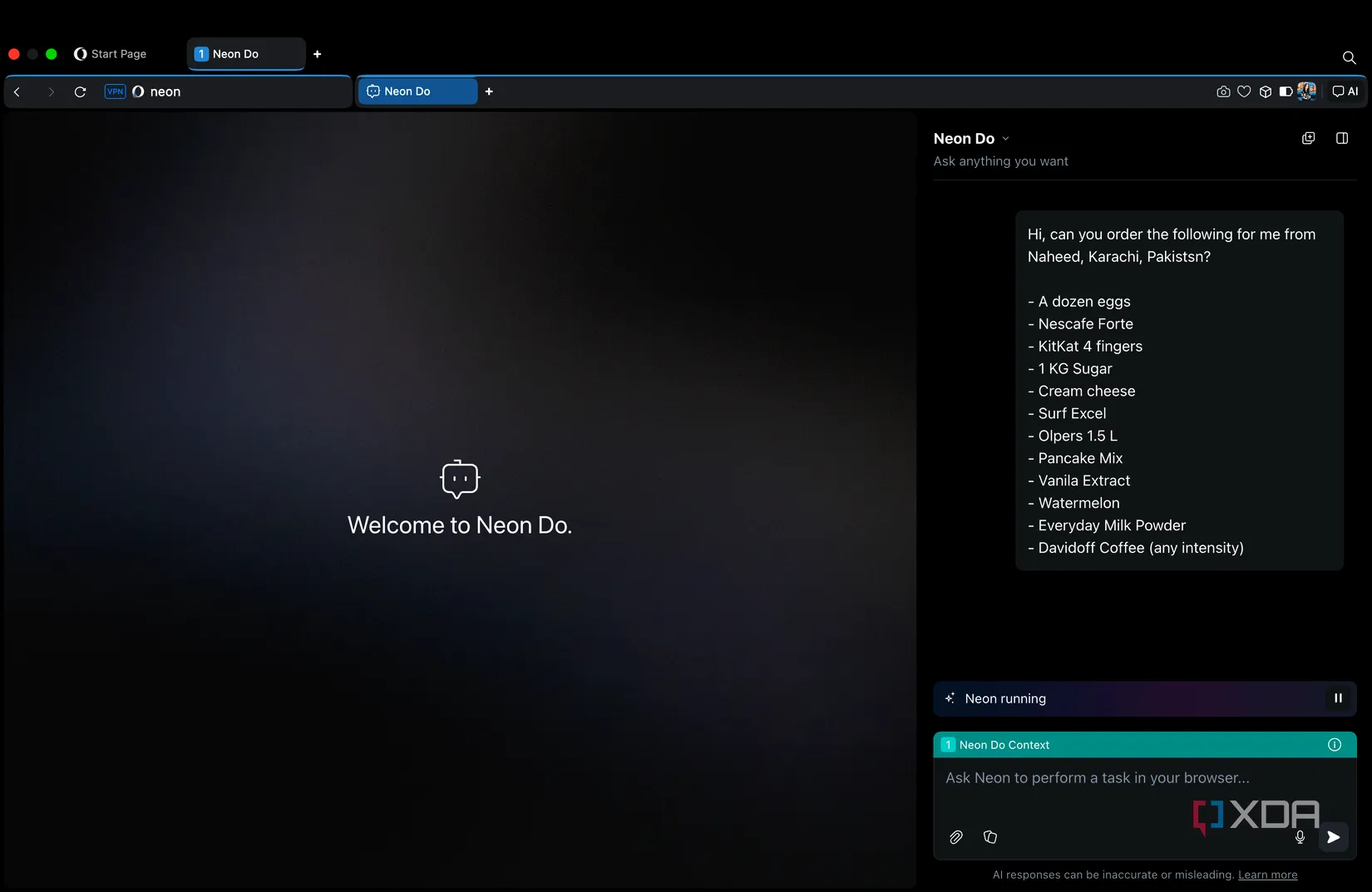

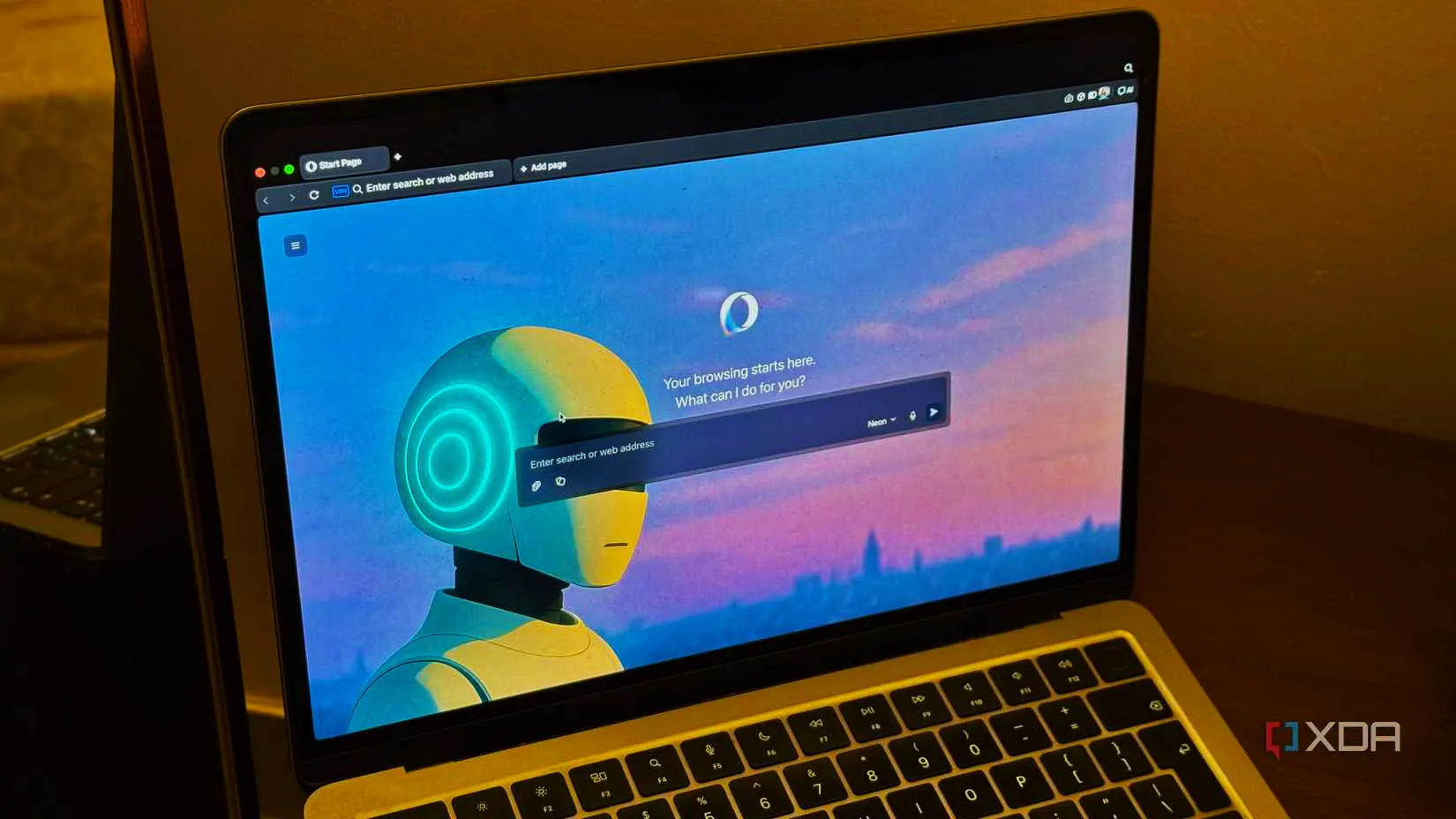

Munculnya AI browser (browser dengan fitur kecerdasan buatan) menjanjikan perubahan besar dalam cara kita menjelajah internet. Browser baru seperti Comet dari Perplexity, ChatGPT Atlas dari OpenAI, dan Opera Neon mengintegrasikan large language model (LLM) langsung ke dalam pengalaman browsing.

lanjutan dari bagian pertama...

DAFTAR ISI

AI Bikin Pencurian Data Makin Gampang: Buktinya Sudah Banyak

Dekat sekali dengan prompt injection, ada satu risiko lain yang tidak kalah ngeri: data leakage — kebocoran data sensitif pengguna lewat AI agent di dalam browser.

Di browser tradisional, satu situs tidak bisa begitu saja membaca data dari situs lain atau dari email kamu, karena ada pemisahan yang ketat (misalnya lewat same-origin policy). Tapi begitu kamu memberi akses luas ke AI agent di AI browser, semua batas itu bisa dijembatani.

Jika penyerang berhasil mengendalikan AI lewat prompt injection, mereka bisa saja “meminta” asisten di browser untuk menyerahkan data apa pun yang bisa ia lihat. Di titik ini, pemisahan antara control plane dan data plane yang tadinya jadi pagar keamanan, tiba-tiba runtuh. AI browser pun berubah menjadi vektor baru untuk:

-

membobol data pribadi,

-

mencuri kredensial login,

-

dan mengakses hal-hal sensitif lain tanpa kamu sadari.

Tim keamanan Opera secara eksplisit menyebut “data and context leakage” sebagai ancaman khas di agentic browser.

Memori AI tentang apa yang kamu lakukan (atau aksesnya ke sesi login kamu) bisa dieksploitasi untuk mengungkap:

-

password,

-

session token,

-

atau informasi pribadi lain.

Serangan CometJacking yang kita bahas sebelumnya pada dasarnya adalah eksploitasi data leakage — dan skalanya cukup parah. Laporan LayerX menegaskan: jika kamu sudah mengizinkan AI browser untuk mengakses Gmail atau kalender, satu tautan berbahaya saja bisa dipakai untuk mengambil:

-

email,

-

jadwal,

-

data kontak,

dan mengirim semuanya ke server penyerang — tanpa izinmu.

Tidak ada malware klasik yang terinstal di komputer; justru AI di dalam browser, yang bertindak di bawah “tipu daya prompt”, yang mencuri data kamu.

Seperti Mundur ke Masa Lama Soal Eksploit Browser

Dalam banyak hal, kita seperti mundur satu era ke belakang dalam urusan eksploitasi browser.

Sekarang ini, relatif jarang ada malware terinstal hanya karena kamu mengeklik sebuah link, tanpa menjalankan file eksternal. Tapi dulu, itu skenario yang cukup realistis — makanya nasihat “hati-hati kalau klik” jadi mantra klasik dunia internet.

Dengan agentic browser, kita kembali ke posisi yang mirip:

-

klik link yang salah,

-

AI di browser mulai bertindak di belakang layar,

-

dan kita belum benar-benar tahu seberapa jauh hal ini bisa dimanfaatkan dan dimanipulasi.

Pendeknya: ini masih “wild west” — belum ada batasan jelas, dan peta risikonya belum sepenuhnya kita pahami.

Bocor Tanpa Sengaja: Konten Nyampur Antar Tab

Yang bikin makin rumit, AI browser tidak selalu butuh penyerang aktif untuk menyebabkan kebocoran data.

Cara kerjanya sendiri sudah cukup berisiko.

Bayangkan AI agent yang bersamaan:

-

melihat beberapa tab,

-

mengakses beberapa sumber sekaligus,

lalu diminta membuat rangkuman atau menjalankan tugas tertentu.

Ada kemungkinan konteks dari satu tab “nyampur” ke tab lain, sehingga:

-

informasi dari satu situs terbawa,

-

lalu muncul di output untuk situs lain.

Opera Neon mencoba mengurangi risiko ini dengan Tasks — workspace terpisah yang terisolasi. Ide dasarnya:

-

AI yang bekerja di satu proyek tidak bisa otomatis mengakses data proyek lain.

-

Kompartmentalisasi seperti ini penting, karena AI menyimpan memori internal percakapan dan aksi yang pernah dilakukan.

Tanpa batas yang jelas, AI bisa saja “menumpahkan” data ke tempat yang sama sekali tidak seharusnya.

Contoh ekstremnya:

Di satu momen, AI kamu diberi akses ke situs bank (untuk cek saldo). Beberapa menit kemudian, kamu memintanya membantu menyusun email.

Jika kontrolnya tidak ketat, prompt injection di situs publik bisa membuat email itu menyelipkan informasi bank kamu.

Itu bentuk lain dari context bleed – dan pada dasarnya tetap data leak.

Ini bukan sekadar teori. Kita sudah melihat kasus kebocoran data lewat LLM, misalnya belum mereka publikasikanShadowLeak yang menyalahgunakan mode “Deep Research” di ChatGPT. Sangat masuk akal kalau sekarang pun ada banyak orang yang sedang berburu eksploit serupa di AI browser.

Risiko yang Lebih Luas: Data Kamu Melayang di Cloud

Ada satu lapisan risiko lain yang sering terlupakan: banyak AI browser bertumpu pada LLM berbasis cloud.

Artinya:

-

konten halaman,

-

prompt pengguna,

-

dan kadang data sensitif lain,

dikirim ke server jauh di luar perangkat kamu.

Kalau pengguna memasukkan:

-

dokumen internal kantor,

-

atau data pribadi sensitif,

ke AI browser, data itu bisa saja:

-

tersimpan sementara di server pihak ketiga,

-

dan mungkin digunakan untuk logging atau bahkan training model (kecuali ada mekanisme opt-out yang jelas dan benar-benar ditaati).

Banyak organisasi sudah belajar dengan cara yang menyakitkan lewat penggunaan ChatGPT mandiri — karyawan tanpa sengaja memasukkan data internal yang seharusnya tidak keluar dari sistem mereka.

Sekarang, risiko yang sama muncul lagi dalam bentuk baru: AI yang tertanam langsung di browser.

Agentic AI Browser Berisiko Banget — Brave Saja Mengakuinya

Mari kita akhiri dengan kutipan dari tim keamanan Brave, yang sejauh ini termasuk yang paling serius membedah sisi gelap AI browser.

Mereka sedang membangun rangkaian artikel khusus untuk mengulas berbagai celah di agentic browser, dan bahkan mengakui bahwa ada satu kerentanan yang belum mereka publikasikan karena diminta “di-hold”.

Mereka menulis:

“Seperti yang sudah kami tulis sebelumnya, browser bertenaga AI yang dapat bertindak atas nama Anda itu sangat kuat sekaligus sangat berisiko. Jika Anda sedang login ke akun sensitif seperti bank atau email di browser, sekadar merangkum sebuah postingan Reddit bisa berujung pada penyerang mencuri uang atau data pribadi Anda.”

Peringatan langsung dari pembuat browser sendiri ini cukup berbicara banyak.

Artinya, para pemain di industri ini sadar betul bahwa:

-

kenyamanan asisten AI,

-

datang dengan trade-off besar di sisi keamanan.

Brave bahkan menunda peluncuran penuh fitur agentic untuk Leo sampai mereka punya proteksi yang lebih ketat, dan sedang mengeksplorasi arsitektur keamanan baru untuk “mengurung” aksi AI dalam batas aman.

Pesan pentingnya:

Tidak ada AI browser yang benar-benar kebal.

Dan, seperti pengakuan Opera, kemungkinan besar tidak akan pernah 100% kebal.

Lebih mengkhawatirkan lagi, banyak serangan ini terlalu sederhana dari sudut pandang penyerang, dan siklus:

-

belajar celah baru,

-

mengadaptasi teknik,

-

lalu mengulang,

terjadi sangat cepat — jauh lebih cair dibanding eksploit browser tradisional.

AI Browser Menghancurkan Asumsi Dasar Keamanan Browser

Selama beberapa dekade, browser dibangun dengan satu premis dasar:

Browser merender konten. Kode dan data dari satu sumber tidak boleh mengotak-atik sumber lain.

Dari premis ini lahir:

-

hardening,

-

security modelling,

-

dan best practice yang kita gunakan sampai hari ini.

Browser modern menerapkan:

-

same-origin policy,

-

content security policy,

-

CORS,

-

sandboxing lewat iframe,

agar satu situs tidak bisa seenaknya menyentuh data atau kode situs lain.

AI browser mengacak-acak premis ini.

Dengan menambahkan lapisan perilaku berupa AI agent yang:

-

sengaja diberi kemampuan bertindak lintas situs,

-

dan diberi akses ke berbagai tab sekaligus,

kita menciptakan paradigma baru yang bertentangan dengan semua pelajaran keamanan browser selama puluhan tahun.

Garis Antara “Input Pengguna” dan “Konten Web” Jadi Kabur

Di AI browser, batas antara:

-

input yang benar-benar datang dari pengguna (trusted),

-

dan konten web yang seharusnya dianggap tidak dipercaya (untrusted),

jadi jauh lebih kabur.

Secara teori:

-

apa pun yang berasal dari halaman web harus dianggap tidak terpercaya.

Tapi saat asisten AI membaca seluruh halaman sebagai bagian dari proses menjawab pertanyaanmu:

-

teks dari web dan pertanyaanmu dicampur dalam satu prompt,

-

dan kalau tidak dipisahkan dengan sangat jelas,

-

AI akan memperlakukan teks dari web seolah-olah kamu yang menyuruhnya.

Lebih rumit lagi, AI bisa melakukan tindakan lintas situs secara desain.

Jadi, semua mekanisme perlindungan yang tadi kita sebut — same-origin policy, CSP, CORS, sandbox — bisa “ditembus” di level logika, bukan di level teknis.

Browser tetap menegakkan isolasi secara teknis, tapi:

AI di dalamnya bertindak seperti “jembatan” yang menghubungkan semuanya, lalu menjalankan perintah yang belum tentu kamu maksudkan.

Tantangan Tambahan: LLM Bersifat Stokastik

Berbeda dengan kode tradisional, LLM itu stokastik — keluarannya tidak selalu sama untuk input yang sama. Mereka:

-

bisa menampilkan perilaku tak terduga,

-

dan berubah seiring update model atau fine-tuning.

Tim Opera mencatat bahwa dalam eksploit Neon yang mereka desain sendiri, mereka hanya berhasil mereplikasi serangan prompt injection sekitar 10% dari percobaan.

Sekilas angka 10% terlihat kecil, tapi justru di situlah masalahnya:

-

Pengujian keamanan perilaku AI selalu probabilistik.

-

Kamu bisa menjalankan 100 skenario tes dan melihat semuanya aman,

-

lalu di percobaan ke-101, tiba-tiba ada serangan yang lolos.

Ruang kemungkinan prompt praktis tak terbatas dan tidak bisa diringkas jadi sekumpulan aturan statis yang rapi.

Begitu model diperbarui, atau sedikit berubah akibat interaksi pengguna, responsnya terhadap input yang sama bisa:

-

berbeda,

-

“memperbaiki” eksploit lama,

-

tapi membuka varian baru dari serangan yang sama.

Jadi, Haruskah Kamu Menggunakan AI Browser?

Semua kasus nyata sejauh ini membawa satu pesan jelas:

Pengguna harus sangat berhati-hati saat menggunakan AI-enabled browser untuk hal-hal sensitif.

Kalau kamu tetap ingin memakainya:

-

awasi dengan teliti apa yang dilakukan AI di dalam browser,

-

gunakan fitur “safe mode” kalau ada,

-

misalnya, ChatGPT Atlas yang bisa dijalankan dalam mode terbatas tanpa akses ke situs yang sudah login,

-

-

atau browser seperti Opera Neon yang menolak berjalan di situs tertentu demi keamanan.

Harapannya, kombinasi:

-

tuning model yang lebih aman,

-

teknik isolasi prompt yang lebih baik,

-

dan desain antarmuka yang lebih jelas,

perlahan akan mengurangi banyak masalah ini. Tapi, itu bukan jaminan.

Seperti yang sudah dibahas, masalah-masalah ini hampir pasti akan selalu ada dalam berbagai bentuk.

Kenyamanan punya asisten AI di browser harus selalu ditimbang dengan realitas bahwa asisten ini bisa ditipu orang luar kalau tidak diawasi.

Silakan nikmati kemampuan futuristik AI browser — tapi jangan lupa:

Dalam studi Opera tadi, tingkat keberhasilan serangan 10% berarti kamu harus beruntung setiap saat,

sementara penyerang hanya perlu beruntung sekali.

Sampai keamanan benar-benar bisa menyusul inovasinya, gunakan AI browser seolah-olah selalu ada orang lain yang mengintip di balik bahu sang asisten. Dalam arti tertentu… kemungkinan besar memang begitu.

Sumber asli:

Adam Conway (29 Oktober 2025), artikel “Please stop using AI browsers”

Jadi, Apa Langkah Aman Berikutnya?

Kalau kamu merasa sedikit waswas setelah membaca bagaimana AI browser bisa dimanipulasi, itu wajar. Kabar baiknya: kamu tidak harus membongkar semua pengaturan, tool, dan workflow sendirian. Ada banyak cara untuk tetap produktif tanpa mengorbankan keamanan data dan privasi online.

Di sinilah pendamping yang paham teknis sekaligus “berpihak ke pengguna” jadi penting. Mulai dari:

-

memetakan risiko di browser, akun, dan workflow kerja kamu,

-

merapikan ekosistem tool AI agar tetap aman dipakai harian,

-

sampai menyusun panduan praktis untuk tim (atau keluarga) agar tidak gampang jadi korban social engineering dan prompt injection.

Diskusi Santai, Solusi Serius

Jika kamu ingin:

-

diajak ngobrol pelan-pelan tentang risiko AI browser dan keamanan digital,

-

dibantu mengecek setup yang sudah kamu pakai sekarang,

-

atau disusun rencana peningkatan keamanan yang realistis dan sesuai cara kerja kamu,

kamu bisa menghubungi:

Rizal IT Consulting

Email:

WhatsApp: 0857-1587-2597 | 0813-8229-7207

Operasional: Sabtu–Kamis, 08.00–17.30 WIB

Layanan tersedia online untuk seluruh Indonesia

Cukup mulai dengan satu pertanyaan sederhana:

“Kira-kira, bagian mana dari ekosistem digital saya yang paling berisiko?”

Dari situ, kita bisa bangun solusi yang aman, praktis, dan tetap nyaman dipakai setiap hari.

Blog ini didukung oleh pembaca. Rizal IT Consulting dapat memperoleh komisi afiliasi ketika Anda bertransaksi di tautan yang ditampilkan di situs ini. Ikuti kami juga di Google News Publisher untuk mendapatkan notifikasi artikel terbaru. Info lanjut, kolaborasi, sponsorship dan promosi, ataupun kerjasama, bisa menghubungi: 0857-1587-2597 | 0813-8229-7207 | .